Von Apple über Google bis Microsoft: Künstliche Intelligenz (KI) ist in aller Munde, und auch die Hardware-Hersteller wollen von dem Kuchen ein Stückchen abhaben. Ob AMD, Intel oder auch Qualcomm – der Vermerk, dass im Prozessor eine NPU zur Beschleunigung von KI steckt, fehlt in keiner Produktankündigung. Doch bringt das überhaupt etwas oder kann ich diese Fähigkeiten beim Kauf (noch) ignorieren?

Wie funktioniert eine KI-Berechnung?

Zunächst ein kurzer Blick darauf, wie Berechnungen bei KI-Anwendungen funktionieren: Zunächst wird eine Anfrage, etwa bei einem Large Language Modell (LLM), in einzelne Einheiten wie einem Wort beziehungsweise einem Teil davon zerlegt und in einen Zahlenwert, den sogenannten Token, umgewandelt. Aus diesem wiederum erzeugt das System einen Kontext-Vektor, der zusätzliche Informationen wie etwa Positionsangaben enthält und die vor- und nachfolgenden Token berücksichtigt, sodass die Analyse erfolgen kann. Erst danach fängt die Welt der Künstlichen Intelligenz an. Dann werden die eingegebenen Daten mit dem abgeglichen, was zuvor als Wissen antrainiert wurde und daraus Antworten konstruiert.

Warum nicht einfach nur die GPU?

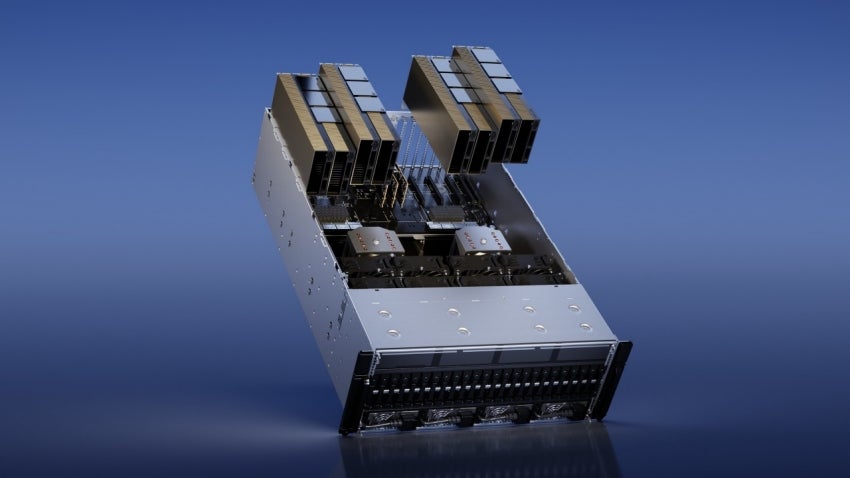

Entscheidend für möglichst schnelle KI-Berechnungen ist eine möglichst hohe Parallelität bei diesen. Eine klassische CPU ist aus diesem Grund nicht optimal, denn einzelnen Befehle werden in einer Reihenfolge abgearbeitet. Umso mehr eignen sich Grafikeinheiten mit ihren vielen Shadern, die zahlreiche Threads parallel verarbeiten können. Das zeigen nicht zuletzt Nvidias spezialisierte Grafikchips. Sie sind zumindest derzeit das Leistungsfähigste für das Betreiben von KI-Anwendungen, etwa LLMs wie eben OpenAIs ChatGPT oder Googles Gemini.

Aktuell macht die GPU das meiste

In aktuellen Notebook- und Desktop-Systemen übernimmt dementsprechend die GPU einen großen Teil der KI-Berechnungen. So vermeldet etwa Intel für seine Meteor-Lake-Prozessoren eine Gesamtleistung bei KI-Anwendungen von 36 TOPS. Davon entfallen jedoch nur elf auf die NPU. Sechs TOPS trägt die CPU bei und ganze 19 TOPS kommen dagegen von der GPU. Allerdings ist diese hierbei nicht sonderlich effizient. Doch gerade bei mobilen Rechnern soll der Stromverbrauch möglichst begrenzt werden. An dieser Stelle bieten die spezialisierten Recheneinheiten erhebliche Vorteile.

Was ist eine NPU?

Der Begriff NPU – Neuronal Processing Unit oder auch neuronale Recheneinheit – bezeichnet eine Erweiterung zur Beschleunigung von KI-Anwendungen, die die Chip-Hersteller in ihren Prozessoren integrieren. Sie sollen möglichst schnell, gleichzeitig aber auch möglichst effizient Muster erkennen und anhand derer gewünschte Ergebnisse erzeugen. Als einer der ersten Hersteller setzte Huawei bei seinem Kirin-970-SoC auf eine entsprechende Erweiterung, die vorrangig für die Verbesserung der Aufnahmen der Kamera genutzt wurde. Andere, auch Google, folgten. Prozessoren für klassische Notebooks oder Desktop-PCs folgen dem Pfad erst mit den aktuellen Generationen. Insbesondere der Erfolg der LLMs und die Integration von KI in Microsofts Windows-Betriebssystem in Form des CoPilots sorgte dafür, dass auch Intel und AMD nachzogen und ihre Prozessoren entsprechend erweitern.

Wie sieht eine neuronale Recheneinheit aus?

Die Herangehensweisen im Aufbau einer NPU können durchaus unterschiedlich sein. Google etwa setzt bei seiner Tensor Processing Unit vorrangig auf Fähigkeiten bei der Matrizenkalkulation und verbaut eine MMU, 256×256-8-Bit-Matrizenmultiplikationseinheit. Allerdings scheint sich eine architektonische Kombination aus einer Gleitkomma- und einer Integer-Einheit durchzusetzen.

AMD, Intel und Qualcomm mit ähnlichen Konzepten

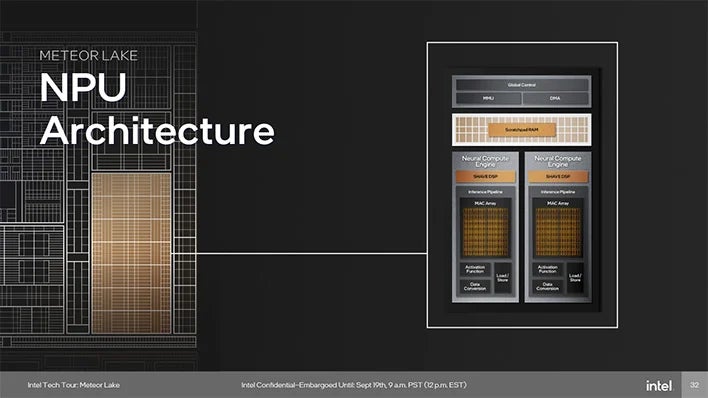

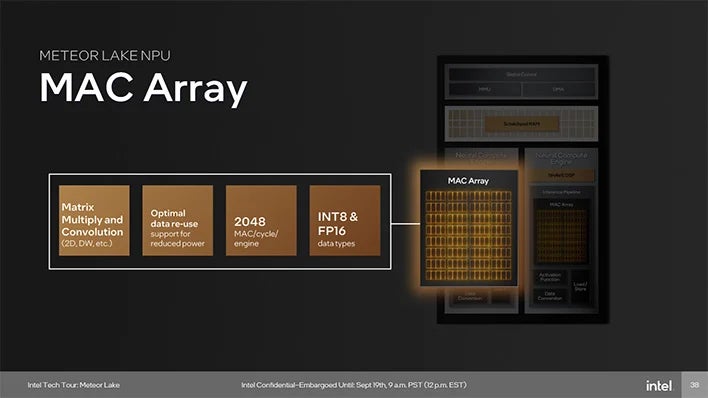

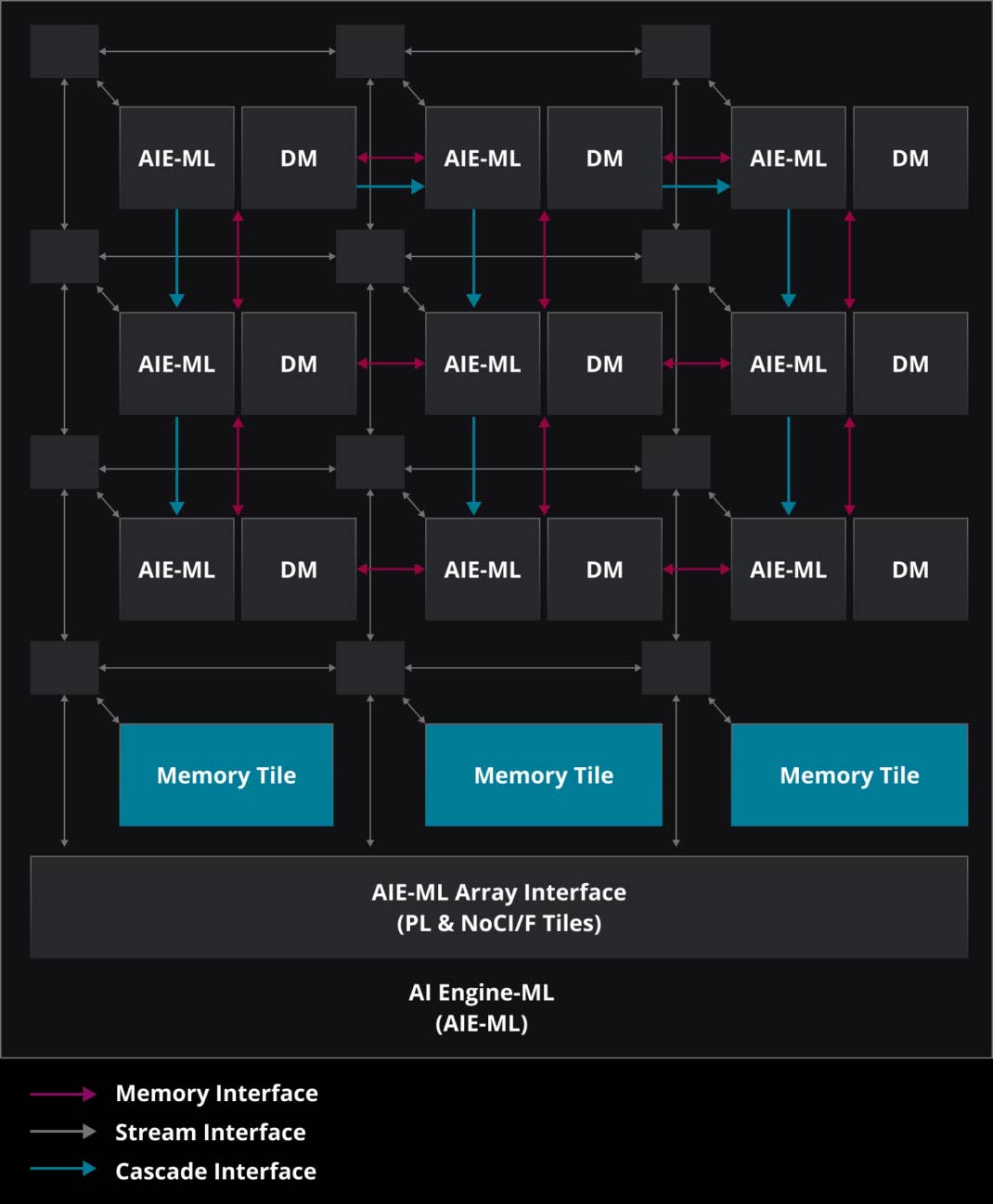

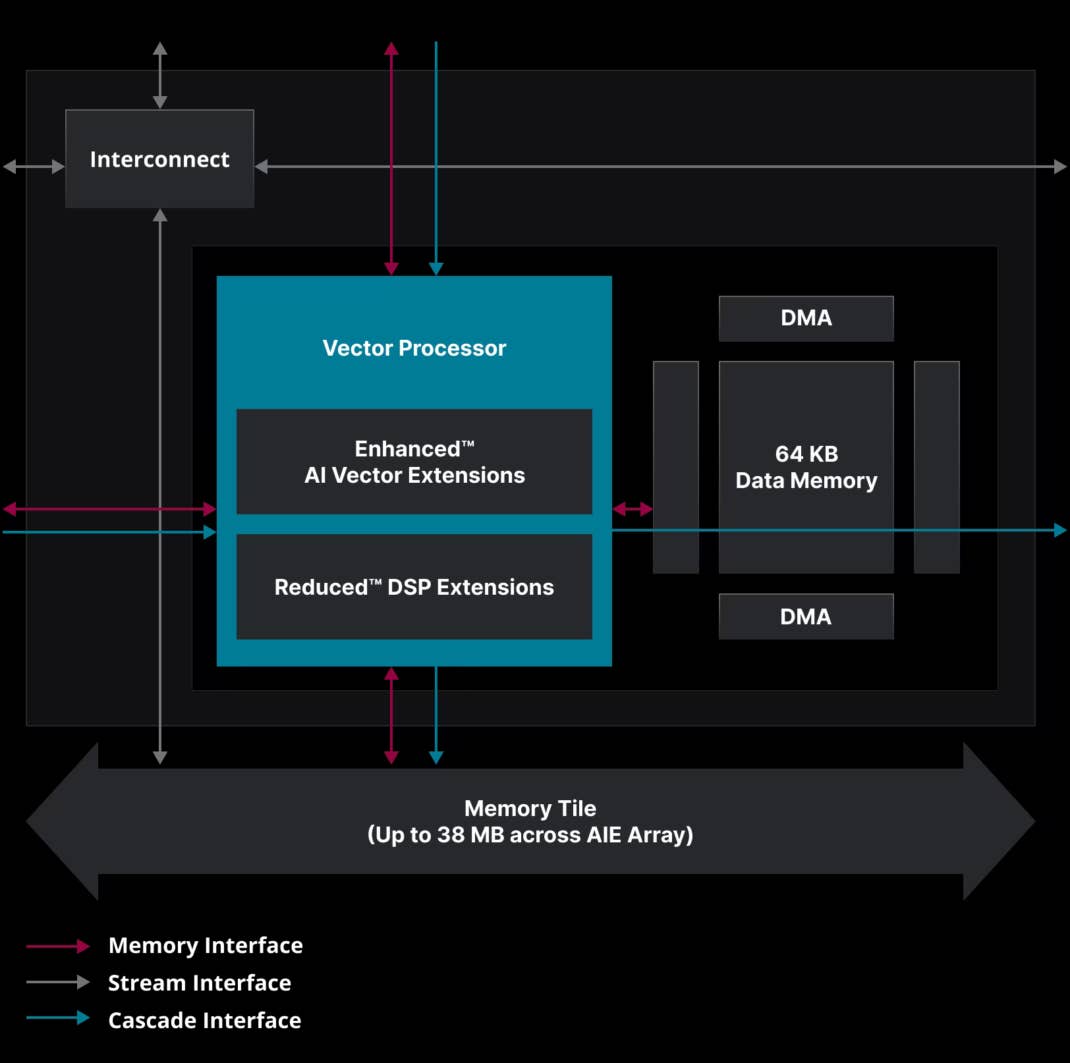

In Intels aktuellen Meteor-Lake-Chips steckt eine NPU, die auf einem MAC-Array basiert, das wiederum aus einer Floating-Point- und einer Integer-Einheit zusammengesetzt wird. Die aktuelle Intel-NPU besteht aus zwei Interference-Pipelines, in der neben einem Signalprozessor jeweils ein Array verbaut wird. AMD setzt bei seiner NPU dagegen auf sogenannte Tiles – Kacheln – in denen ebenfalls ein Vektor- mit einem Integer-Rechenkern kombiniert wird. Die einzelnen Tiles werden zusammen mit einem Speicher zu einer Recheneinheit zusammengefasst. Qualcomm stellt den der skalaren und der Vektor-Einheit zusätzlich eine Tensor-Einheit zur Seite, wobei ein Tensor letztlich eine Anordnung von Zahlen auf einer beliebigen Anzahl von Achsen beschreibt. Auch Vektoren und Matrizen zählen damit zu den Tensoren.

Blick in die Glaskugel: Microsoft will mehr KI – und die braucht Leistung

Künftig könnte der Bedarf an leistungsstarken NPUs tatsächlich steigen, nämlich dann, wenn die Künstliche Intelligenz, die in sie gesteckten Erwartungen erfüllen soll. Denn je komplexer die Anwendungen und die damit verbundenen Berechnungen, desto größer lasten sie auf den Servern, die diese aktuell bereitstellen. Damit müssen die Cloud-Anbieter die dahinterstehenden Rechenzentren erheblich ausbauen. Deren Betrieb ist jedoch vergleichsweise teuer, ihr Energiebedarf ist enorm. Und auch das so wichtige zeitnahe Bereitstellen von Ergebnissen könnte zum Problem werden.

Hinzu kommen Fragen nach der Sicherheit der Daten, wenn die Anwendungen der künstlichen Intelligenz vorrangig in der Cloud ausgeführt werden. Dann sind die Nutzerdaten letztlich für den jeweiligen Anbieter vollständig einseh- und damit auch auswert- und vermarktbar.

Microsoft scheint daher künftig wieder stärker auf den Client-PC zu setzen. Die KI-Funktion CoPilot soll integraler Windows-Bestandteil werden. Nach den Vorstellungen der Softwareschmiede muss ein KI-PC künftig mit einer NPU ausgestattet werden, die mindestens 45 TOPS leistet. Im Consumer-Bereich gibt es aktuell jedoch noch nichts, dass eine solche Leistung bieten würde. Erst der Qualcomm Snapdragon Elite X, der in einigen Wochen auf den Markt kommen wird, schafft diese Hürde.

KI beim PC-Kauf beachten?

Trotz der vollmundigen Ankündigungen des Redmonder Softwarekonzerns ist derzeit noch nicht vollends absehbar, ob Künstliche Intelligenz tatsächlich zu dem nächsten großen Ding auf dem heimischen PC wird – auch wenn einiges dafür spricht: KI hat durchaus das Potential die Interaktion zwischen Mensch und Computer grundlegend zu verändern. Anstatt Werkzeuge bedienen zu müssen, lassen künftig intelligente Assistenten aus Ideen fertige Lösungen werden. Dann kommt auch den Erweiterungen zur Beschleunigung der KI eine größere Bedeutung zu. Wer aber jetzt einen Computer benötigt, muss KI-Fähigkeiten noch nicht beim Kauf berücksichtigen. Im Gegenteil. Sowohl AMD als auch Intel haben ihre aktuellen Chips – abgesehen von der NPU – im Vergleich zu den Vorgängern nur begrenzt weiterentwickelt. Wer sich also derzeit für einen AMD Ryzen 7000 oder einen Intel-Core-Prozessor der 13. Generation entscheidet, kann kaum etwas falsch machen, aber im Vertgleich zu den neuen Chips bares Geld sparen.

Manche Sachen sind nur zeitliche Erscheinung.

So wie 3D auf dem Fernseher.

Jeder Hersteller hats eingebaut und wo ist heute die Technologie?

Wozu braucht ein ganz gewöhnlicher Verbraucher, der ein paar Nachrichten lesen oder Videos im Internet anschauen will, oder ein paar E-Mails abrufen oder gelegentlich ein Brief schreiben diese KI?

Es wird wieder etwas gebaut und verkauft, was nur wirklich wenigen brauchen.

Ein Film, mit originalen Stimmen zu synchronisieren, ohne auf die Studios zu warten, bis der Film in Landessprache rauskommt, oder weil es nur eine Stimme für mehrere Schauspieler gibt, alleine dafür kann ich mir die KI sehr gut vorstellen, sonst sehe ich für mich keine Verwendung.

Vielleicht kann mir jemand auf die Sprünge helfen und erzählen, wofür kann ich und die andere so eine KI im tagtäglichen Leben gebrauchen.

Maschinelles Lernen und Künstliche Intelligenz werden ja schon heute an vielen Stellen eingesetzt, ohne dass es uns unbedingt bewusst ist. Kaum ein Bild einer Smartphone-Kamera, das nicht durch einen solchen Prozess optimiert wurde. An anderen Stellen braucht es vielleicht noch etwas mehr Fantasie. Aber wer heute Copilot benutzt bekommt zu seinen Suchergebnissen bereits eine KI-generierte Erklärung. Künftig sind Webseiten u.U. überflüssig, weil eine KI präzise die gesuchten Informationen viel zielgenauer und schneller liefert. Auch eine Verknüpfung mit einem digitalen Assitenten ist dann nicht weit.